线性回归与基础知识 线性回归简要说明

线性回归广泛用于机器学习中通过将线性方程拟合到数据来观察两个或更多个变量之间的关系。

线性回归用于对一个或多个对输出变量有影响的自变量进行预测分析。输出必须是连续的并且取决于输入变量。

- 如果只有一个自变量,那么线性回归称为单变量线性回归

- 如果有多个独立变量对因变量产生影响,则回归称为多变量线性回归。

示例:

假设房屋的价格取决于房屋的大小,房屋大小是自变量,价格是因变量,取决于房屋的大小:

然而,可能有多个变量会影响房子的价格如房间数量、楼层等..

线性回归/假设的等式具有以下形式:

单变量:

多个变量:

(其中x0始终为1)

函数h(θ)是基于输入变量的预测。theta0和theta1是学习参数(回归系数),从等式中,你可以注意到它和斜率-截距方程是一样的。

因此,这与斜率方程相同,数据必须显示一些趋势以拟合分析的最佳线。如果数据没有显示任何趋势,那么使用其他模型是明智的。

这些预测是根据回归系数的值做出的。为了使数据拟合最佳的直线,我们必须定义一种方法来衡量机器学习模型的效率。

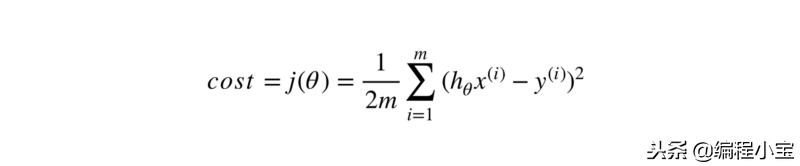

成本是定义机器学习模型执行方式的项。成本越高,预测就越糟糕。目标是尽可能降低成本。

成本公式:

回归系数的取值可由法向方程计算:

如果机器学习数据集较小且具有较少的特征或变量,则Normal equation是有用的,但如果变量的大小变得高于1000,那么最好使用其他方法,如梯度下降。

梯度下降 :正规方程的复杂性使得梯度下降对于具有大特征变量的数据非常有用。

梯度下降是通过获取函数的导数然后沿着方向采取迭代步骤并同时更新参数来找到函数的最小值的方法。

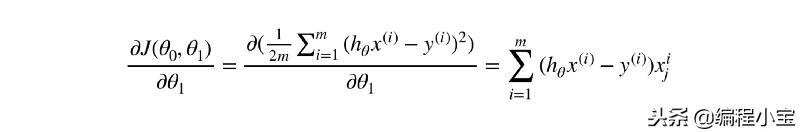

成本函数的导数将为我们提供函数最小值的方向。对于那些不知道微积分的人来说,这是为你计算的导数:

对于theta0:

对于theta1:

请注意,梯度只会向我们提供函数最小值的方向。我们将不得不通过在斜率/梯度方向上采取迭代步骤来更新权重。

更新参数的公式为:

这里alpha是学习率。学习将步长决定为函数的最小值。如果学习速率太小,函数将永远不会收敛或收敛将花费大量时间。而且,如果学习率太高,优化可能会不稳定(跳到最佳状态,甚至可能变得更糟而不是更好)。最好选择像0.01,0.1等小的学习率...

为了找到最好的参数,我们需要通过多次迭代来运行梯度下降算法。但是什么时候停止?

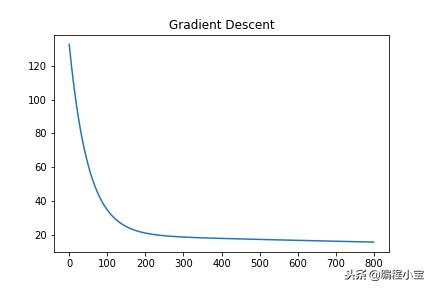

可视化梯度下降的最佳方法是绘制每个步骤的成本函数。

当您查看图形时,您会注意到经过一定次数的迭代后,图形处于最低位置。这解释了一旦函数处于最小值,无论梯度下降算法采用多少次迭代,它都将保持在最小值。

,免责声明:本文仅代表文章作者的个人观点,与本站无关。其原创性、真实性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容文字的真实性、完整性和原创性本站不作任何保证或承诺,请读者仅作参考,并自行核实相关内容。文章投诉邮箱:anhduc.ph@yahoo.com